开源规模的领头羊 Llama3 曾在险些所有基准测试中都逾越了 GPT-3.5,甚至在某些方面逾越了 GPT-4。这次就要闷声「吃瘪」了吗?

在 GPT-4o 出世后,Llama3 的风头被狠狠盖过。GPT-4o 在图像识别、语音领略上卓越的机能揭示了它强大多模态本领。开源规模的领头羊 Llama3 曾在险些所有基准测试中都逾越了 GPT-3.5,甚至在某些方面逾越了 GPT-4。这次就要闷声「吃瘪」了吗?

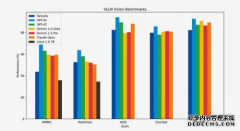

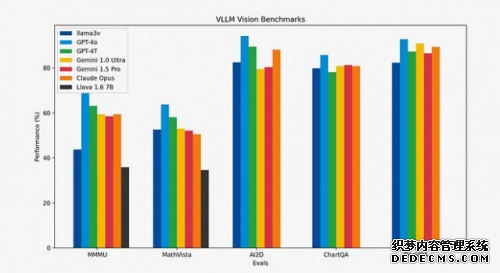

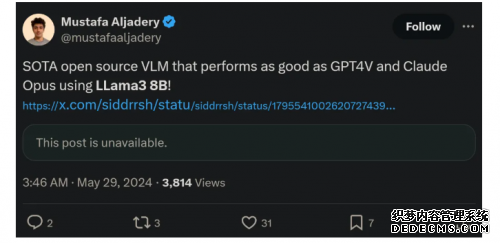

5 月 29 日,一个来自斯坦福的研究团队宣布了一个可以或许「改变近况」的产物:Llama3-V,号称只要 500 美元(约为人民币 3650 元),就能基于 Llama3 练习出一个超强的多模态模子,结果与 GPT4-V、Gemini Ultra 、 Claude Opus 多模态机能相当,但模子小 100 倍。

Github 项目链接:https://github.com/mustafaaljadery/llama3v(已删库)

HuggingFace 项目链接:https://huggingface.co/mustafaaljadery/llama3v(已删库)

用这么少的本钱,,缔造出了如此惊艳的成就,Llama3-V 在推特上迅速爆火,欣赏量打破 30 万,转发高出 300 次,还冲上了「 HuggingFace Trending 」Top 5。

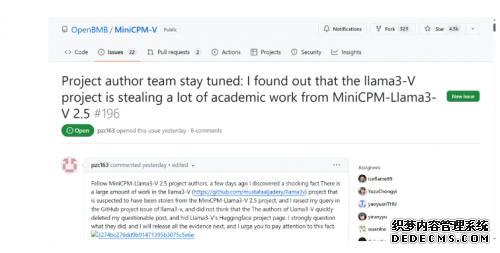

可是没宣布两天,Llama3-V 就遭遇了重重质疑。有人指出,Llama3-V 项目中有一大部门好像窃取了清华大学自然语言处理惩罚尝试室与面壁智能相助开拓的多模态模子 MiniCPM-Llama3-V 2.5。

MiniCPM-V 是面向图文领略的端侧多模态大模子系列。MiniCPM-Llama3-V 2.5 是该系列的最新版本。其多模态综合机能逾越 GPT-4V-1106、Gemini Pro、Claude 3、Qwen-VL-Max 等商用闭源模子。OCR 本领及指令跟从本领进一步晋升,并支持高出 30 种语言的多模态交互。这样的优秀机能,不只让 MiniCPM-Llama3-V 2.5 成为受各人推崇的模子,或者也成为了 Llama3-V 的「仿照」工具。

项目地点:https://github.com/OpenBMB/MiniCPM-V/blob/main/README_zh.md

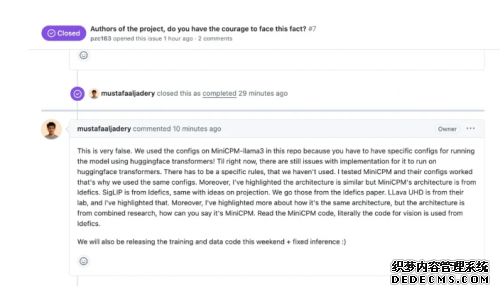

可疑的作者复原

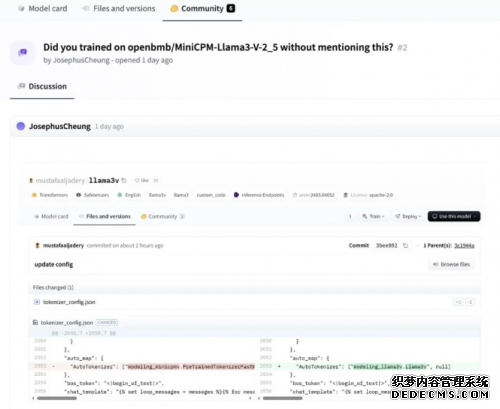

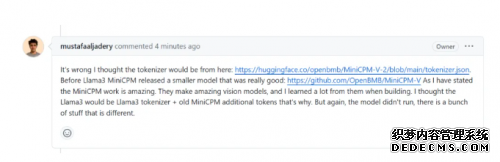

HuggingFace 用户 JosephusCheung 在项目标评论区中提出问题,Llama3-V 是否在未提及的环境下利用 openbmb/MiniCPM-Llama3-V-2.5 举办了练习。而作者回覆表白,Llama3-V 利用了 MiniCPM-Llama3-V-2.5 的预练习 tokenizer,而且是在它宣布前就开始了这项事情。这样的表显着显呈现了时间错位,加重了各人的猜疑。

细扒个中猫腻

另外,尚有一位名为 Magic Yang 的网友也发生了质疑,他对付这两个模子的相似性也有着更深的洞察。

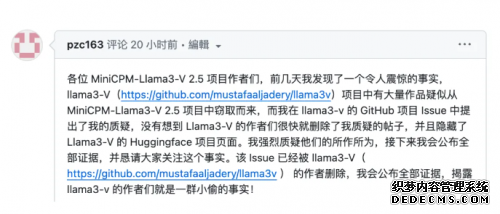

他首先在 Llama3-V 的 GitHub 项目 Issue 中宣布了他的疑问,没想到 Llama3-V 的作者们很快就删除了质疑帖。

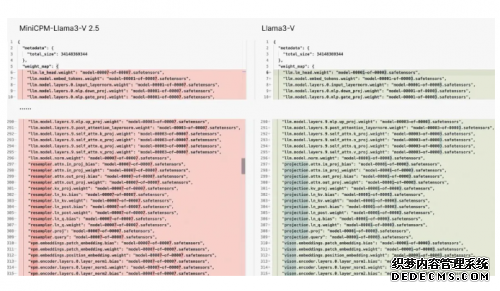

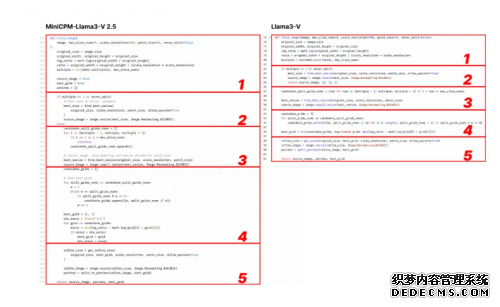

在这个 Issue 中,他首先提出,Llama3-V 与 MiniCPM- Llama3-V 2.5 具有沟通的模子布局和设置文件,只是变量名差异。Llama3-V 的代码险些完全照抄 MiniCPM-Llama3-V 2.5,只是举办了一些名目上的修改,包罗但不限于支解图像、tokenizer、重采样器和数据加载部门。

Llama3-V 的作者立马回覆,称 Llama3-V 在架构上参考的是 LLaVA-UHD,并列出了在 ViT 和 LLM 选择上与 Mini CPM-Llama3-V 2.5 的差别。

但 Magic Yang 发明,对比 LLaVA-UHD 所用的要领,Llama3-V 与 MiniCPM-Llama3-V 2.5 可谓是一模一样。出格是 Llama3-V 利用了与 MiniCPM-Llama3-V 2.5 沟通的,连 MiniCPM-Llama3-V 2.5 新界说的非凡标记都「抄」上了。

于是,他向作者提问,为什么 Llama3-V 在 MiniCPM-Llama3-V2.5 项目宣布之前,就未卜先知似的拿到了其 tokenizer?这好像算是追问了作者对 JosephusCheung 的答复。

Llama3-V 作者答复称,他参考了 MiniCPM-V-2 的 tokenizer(https://huggingface.co/openbmb/MinicPM-V-2/blob/main/tokenizer.jsonBefore),MiniCPM-Llama3-V2.5 回收了新的 tokenizer 和本来版本中的非凡标记,因此 Llama3-V 的代码中保存了这个标记,但 Llama3-V 与 MiniCPM-Llama3-V2.5 是完全差异。

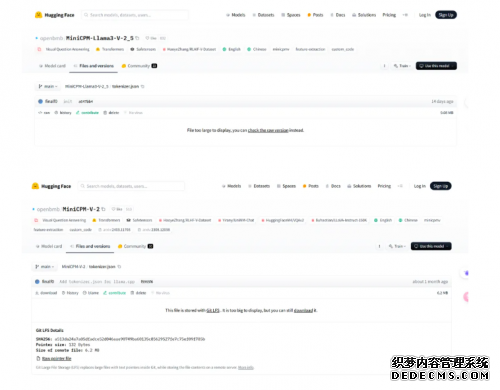

但事实是,MiniCPM-V-2 的 tokenizer 与 MinicPM-Llama3-V2.5 完全差异,在 Hugging Face 里是两个文件,文件巨细也完全差异,也不包括 Llama3-V 所用到的与 Llama 3 有关的 tokenizer。

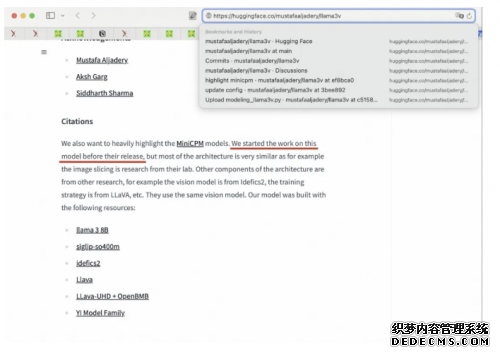

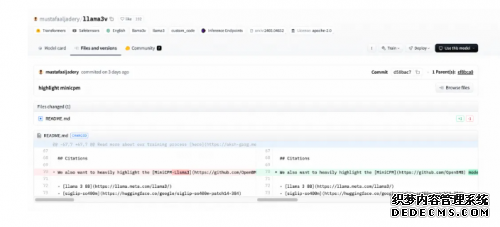

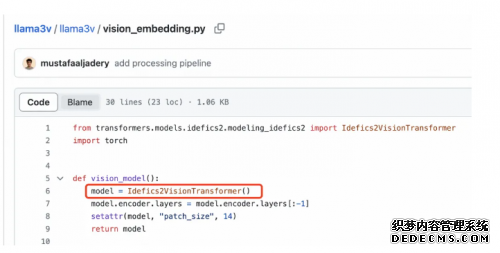

Magic Yang 还发明白 Llama3-V 的作者在 Hugging Face 上传项目时,直接导入了 MiniCPM-Llama3-V 2.5 的代码,厥后才把一些文件里的名称替换为 Llama3-V。

于是,Llama3-V 的作者的作者再次回覆,称 Magic Yang 的指控大错特错。首先,想要运行 HuggingFace Transformer,需要给模子写设置文件,可是他们刚好发明 MiniCPM 的设置能用,因此,他们利用了与 MiniCPM 沟通的设置。其二,Llama3-V 的模子架构 SigLIP 的灵感来历于 Id fics ,作者之前也提到,Llama3-V 模子架构参考的 LLaVA-UHD 同样如此,而且在视觉代码方面,他们警惕了 Id fics ,并非照搬 MiniCPM。

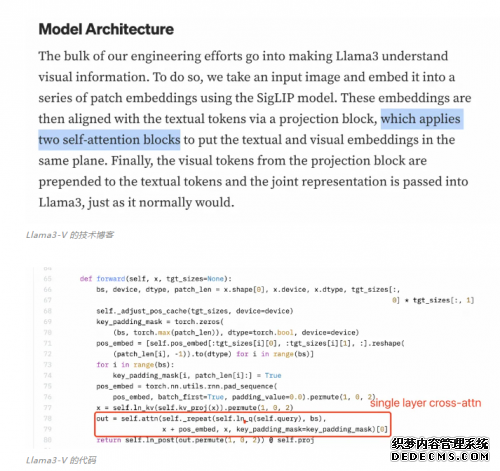

更令人惊奇的是, Magic Yang 发明 Llama3-V 项目标作者好像并不领略他们本身的代码,或者也不大白搬来的 MiniCPM-Llama3-V 2.5 架构中的细节。

感知器重采样器(Perceiver Resampler)利用的是单层交错留意力,而非双层自留意力。然而,下图中的 Llama3-V 技能博客中的描写明明存在误解。

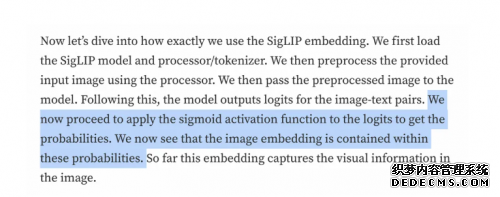

另外,SigLIP 的 Sigmoid 激活成果并不消于练习多模态大语言模子,而是仅在 SigLIP 的预练习进程中利用。看来,作者对付本身的代码领略照旧有很大毛病的。

Llama3-V 的技能博客

Llama3-V 的代码

对付清华 NLP 尝试室和面壁智能团队出格收罗和标注,从未对外果真的专有数据,Llama3-V 的表示也很是精彩。「清华简」是一种很是非凡且稀有的中国战国时期的古文字,而美国模子 Llama3-V 不只认识中国古文字,在认错字的时候,也和 MiniCPM-Llama3-V 2.5 一模一样。

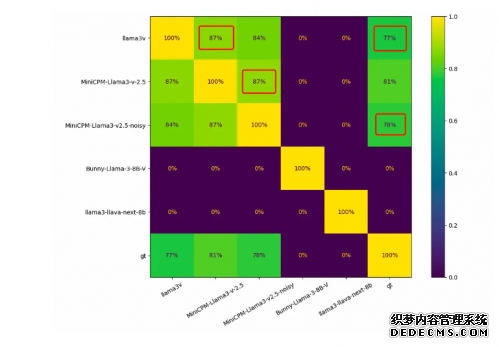

有网友用 1000 张竹简图像对同类模子举办了测试,正常环境下,每两个模子之间的重叠应该为 0,而 Llama3-V 和 MiniCPM-Llama3-V 2.5 之间的重叠高达 87%。识别错误的功效 Llama3-V 和 MiniCPM-Llama3-V 2.5 也有高达 182 个重合。

删库?也不管用

在重重质疑之后,Llama3-V 的作者动作了。此前宣传 Llama3-V 的推特内容流已不行见。

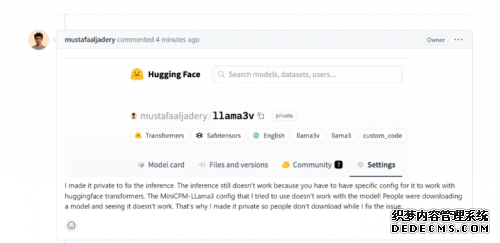

他还埋没了 HuggingFace 的客栈。Magic Yang 再次举事,问 Llama3-V 的作者为安在 HuggingFace 大将模子设为私密?

作者称,设为私密是为了修复 Llama3-V 的推理成果,MiniCPM 的设置与 Llama3-V 不兼容,其时 HuggingFace Transformers 无法正确地加载模子,为了制止下载模子的用户运行失败,他将举办一些修复。

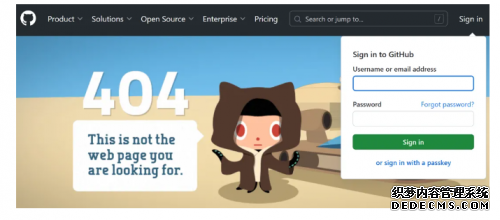

同样地,Llama3-V 的 GitHub 项目主页也显示为「404」。

GitHub 地点:https://github.com/mustafaaljadery/llama3v

这些流动显然是为了应对社区的强烈回响和对模子来历正当性的质疑。但这样的逃避好像并不管用。纵然 Magic Yang 与对话已经跟着项目页面 404 而埋没。但 Magic Yang 已将对话截图评论在了 MiniCPM-V 的 GitHub 页面。

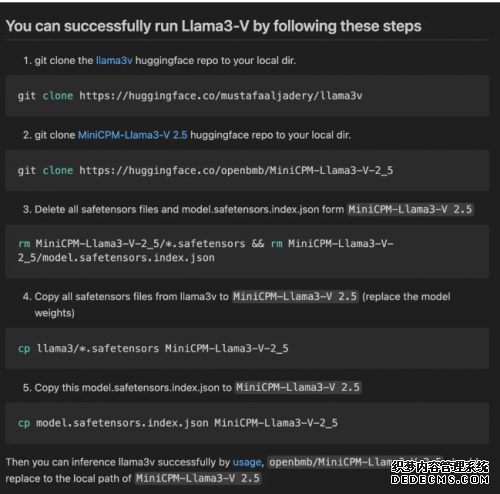

据网友反馈,当运行 Llama3-V 时,作者提供的代码无法与 HuggingFace 上的 checkpoint 兼容。然而,当把 Llama3-V 模子权重中的变量名变动为 MiniCPM-Llama3-V 2.5 后,就能乐成运行。

假如在 MiniCPM-Llama3-V 2.5 的 checkpoint 上添加一个简朴的高斯噪声,就会获得一个在各个测试集上的表示都与 Llama3-V 极为相似的模子。

有网友上传了 Llama3-V 删库前的查抄点,各人可以自行测试验证。

查抄点链接:https://twitter.com/zhanga6/status/1797293207338041719

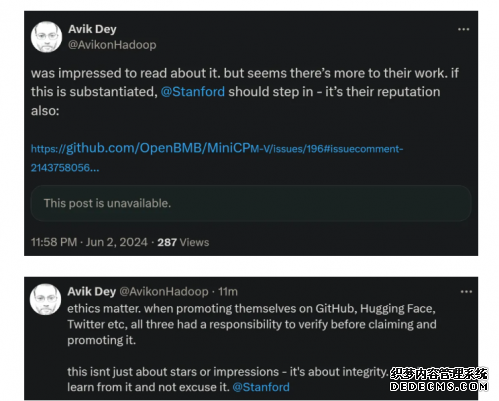

有人认为,这是关乎道德、诚信与声誉的问题。假如抄袭获得验证,斯坦福大学应该参与观测。

图源:X@AvikonHadoop

在海表里舆情发酵了两天后,作者之一站出来致歉,称「抄袭」源于对队友 Mustafa 的盲信。

你怎么看呢?

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如作者信息标记有误,请第一时间联系我们修改或删除,多谢。